联邦学习-吴方照

Contents

微软 吴方照

浙大 吴超主持

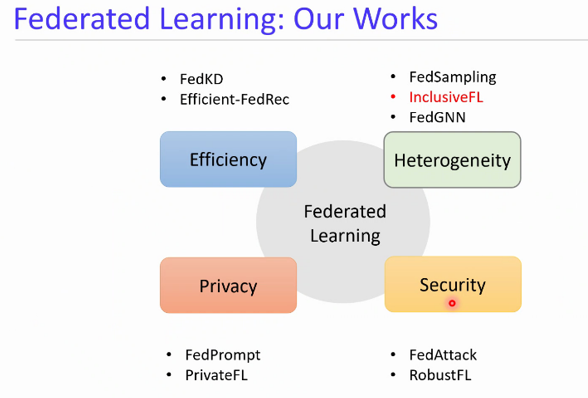

联邦学习核心挑战

- 效率 通信,计算

- 异构性 数据的异构性,设备的异构性

- 隐私保护 处理之后的隐私泄露低于不处理的,MPC

- 安全

-

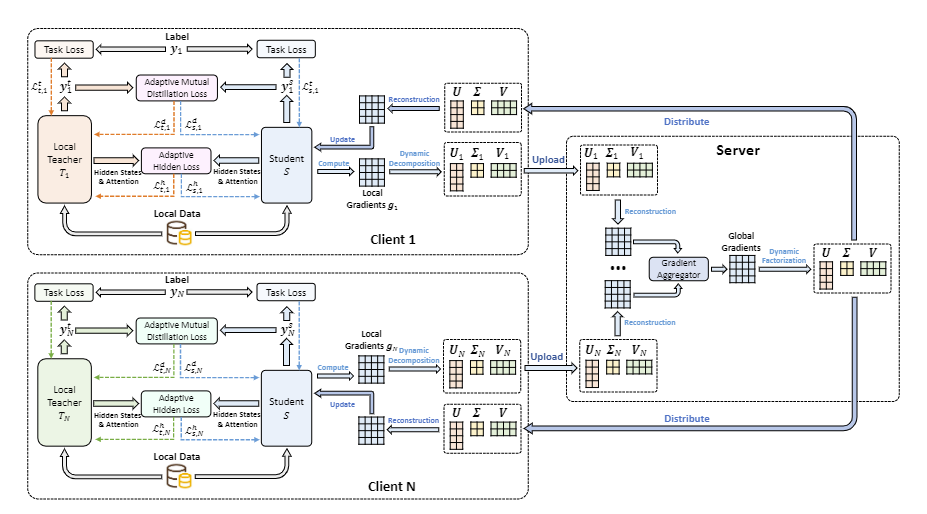

Communication-efficient federated learning via knowledge distillation,Nature CommunicationsFedKD:解决通信开销—>压缩模型->通过知识蒸馏

在每次迭代中,每个客户端基于对标记的本地数据和从彼此提取的知识的监督,同时计算本地教师模型和学生模型的更新。教师模型在本地更新,而学生模型在不同的客户端之间共享,并通过协作学习。教师模型只能从本地数据中学习,而学生模型可以看到所有客户端的数据,教师也可以从学生模型中提取知识。

-

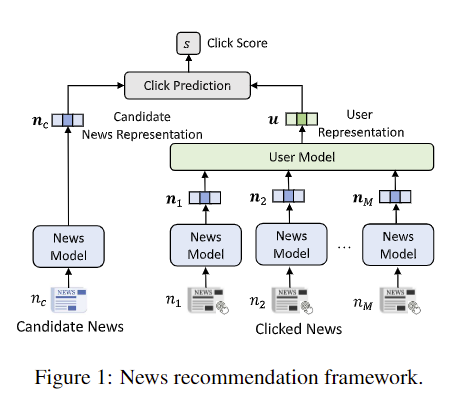

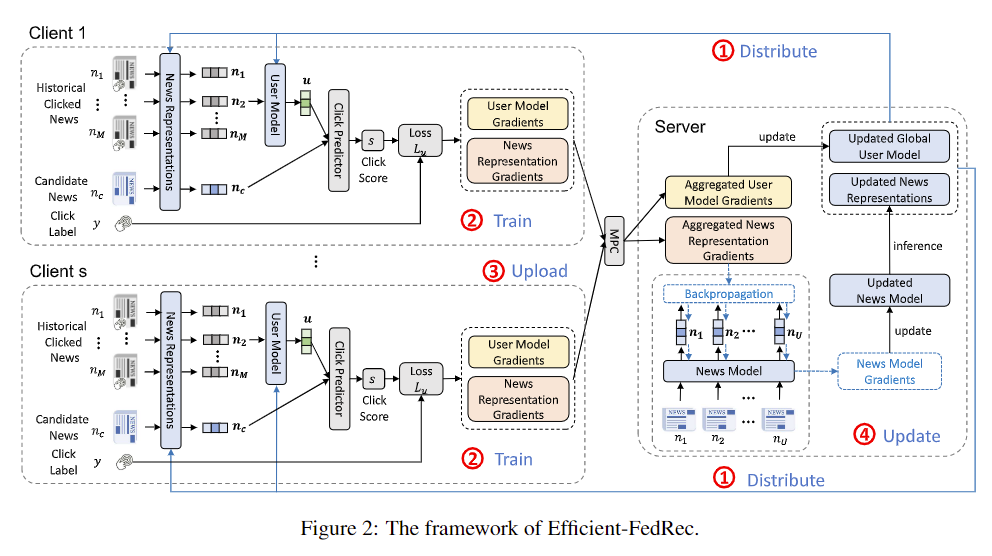

Efficient-FedRec:Efficient Federated Learning Framework for Privacy-Preserving News Recommendation,EMNLP 2021Efficient-FedRec:计算上更加高效,利用任务的特性,特殊场景—新闻推荐

新闻模型:新闻的文本内容中得到一个语义的文本表示。

用户模型:把用户看过的新闻聚合成一个向量来表示用户的兴趣。将两个结合起来。来表示用户点击新闻的可能性分数。

新闻的内容公开的可以训练一个大的新闻模型(隐私性比较低的,计算量比较大)

用户读过的内容,隐私要求高的用户模型->用户模型放在本地,新闻模型放在服务器

联邦推荐,个性化联邦学习

-

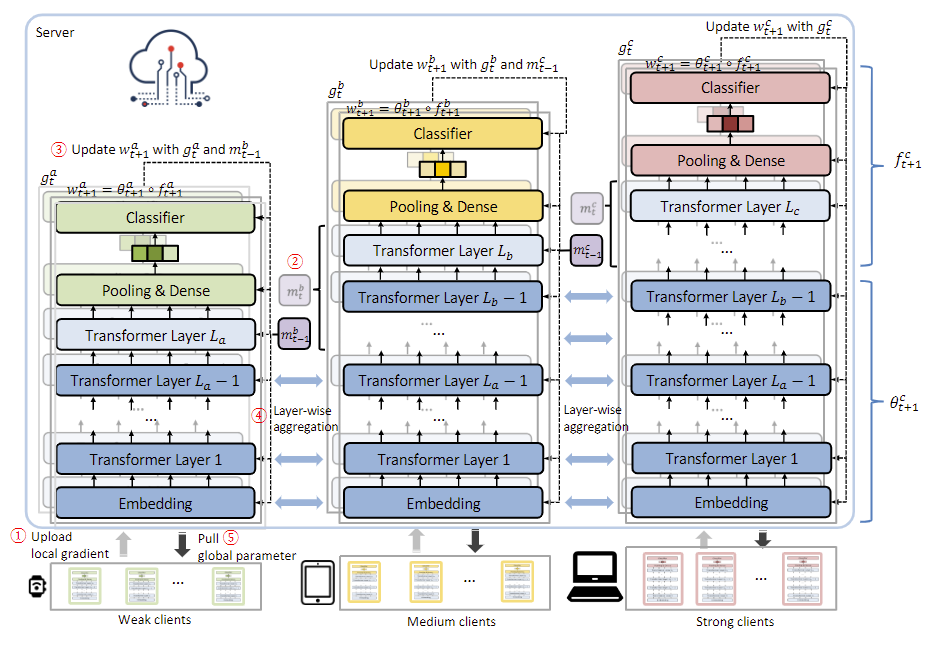

No One Left Behind:Inclusive Federated Learning over Heterogeneous Devices,KDD 2022InclusiveFL:设备的异构性–手机,电脑,平板,手表。。

按照计算能力分配不同规模的模型。nlp模型堆了很多层,按层进行划分,并且底层的模型的泛化能力比较好的。

为了实现不同大小模型的融合,不同的模型共享一个底层,知识融合更加方便(将共享的底层相加)

-

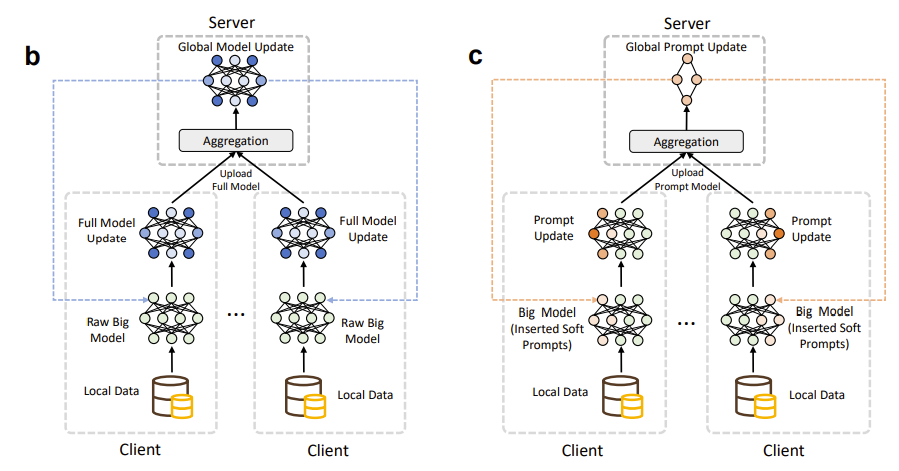

FedPrompt:隐私方面

差分隐私,DP/LDP,会对模型进行扰动,减低模型效率,LDP+Prompt-tuning

应用比较有限,仅能解决训练阶段的要求

先对模型添加一些额外的参数(Prompt),然后再添加一些扰动来保证隐私。

-

FedAttack:Effective and Covert Poisoning Attack on Federated Recommendation via Hard Sampling,KDD 2022FedAttack:安全性

有毒的数据或者模型进行攻击

machine unlearning:这是一篇关于机器遗忘学习的paper, 顾名思义, machine unlearning就是让训练好的模型遗忘掉特定数据训练效果/特定参数, 以达到保护模型中隐含数据的目的.

激励机制 — 吸引用户参与联邦学习,真实大众用户

通信上–理论上保障解耦,指标-》通信开销(单轮通信量,总轮数),准确率性能。数据集和模型大一些,使得通信开销降低明显些。

Author kong

LastMod 2022-06-24